算法研究围绕多模态交互与建模,业务涉及LLM大模型和图像生成。

我目前就职于华为,终端云小艺。硕士毕业于中国科学技术大学, 导师是於俊副教授, 企业导师是平安科技美国硅谷研究院院长Peng Chang和Iek-Heng Chu。本科毕业于广州大学, 导师是人工智能研究院执行院长李进教授和王显珉副教授。目前参与发表文章10余篇。

本科和研究生期间以来经常参加算法比赛,累计国内外AI算法竞赛获奖20余次,掌握丰富的比赛经验和策略。 此外,担任阿里安全学生专家小组成员, 阿里安全挑战者计划排行榜第七名。

我的研究领域包括:

- 多模态交互与建模 (CV/NLP)

- AIGC

- 细粒度图像识别

- 鲁棒机器学习

我的业务方向包括:

- 大语言模型

- 探索性数据分析 (EDA)

- 数据挖掘

- 风格迁移 (Autoencoder、GAN、Diffusion model)

- 目标检测

📝 发表论文

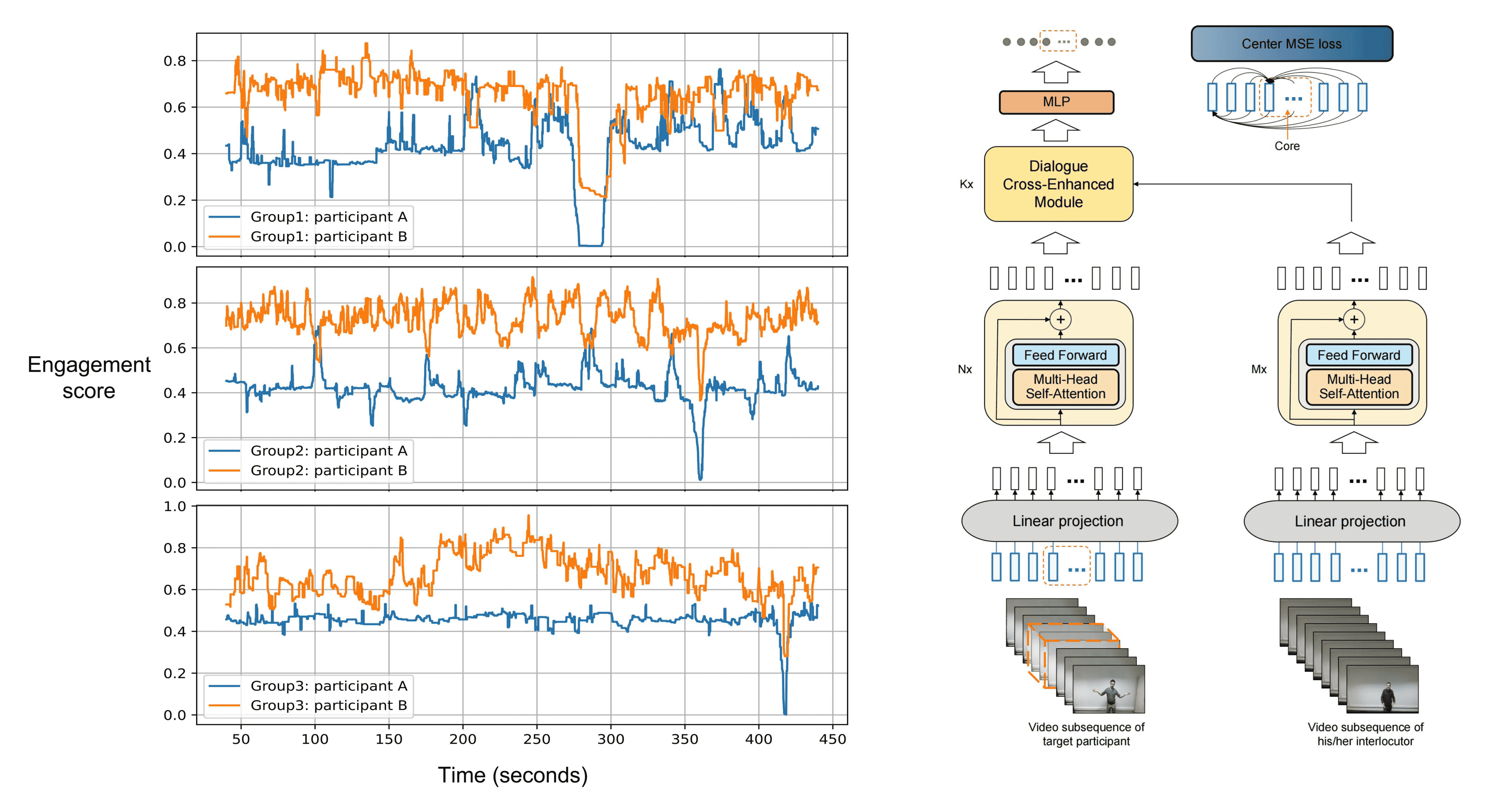

Dialogue Cross-Enhanced Central Engagement Attention Model for Real-Time Engagement Estimation

Jun Yu, Keda Lu, Ji Zhao et al. (学生一作)

- 为了解决sliding window的重复推理问题,提出cente-based sliding window,推理效率提升100%。

- 提出基于自注意力机制的核心参与度注意力模型,超越先前的SOTA的BiLSTM模型,推理效率提升300%。

- 基于交叉注意力提出交叉增强模块,和核心参与度注意力模型无缝集成,交互对话者的特征,实现了实时参与度估计任务新的SOTA。

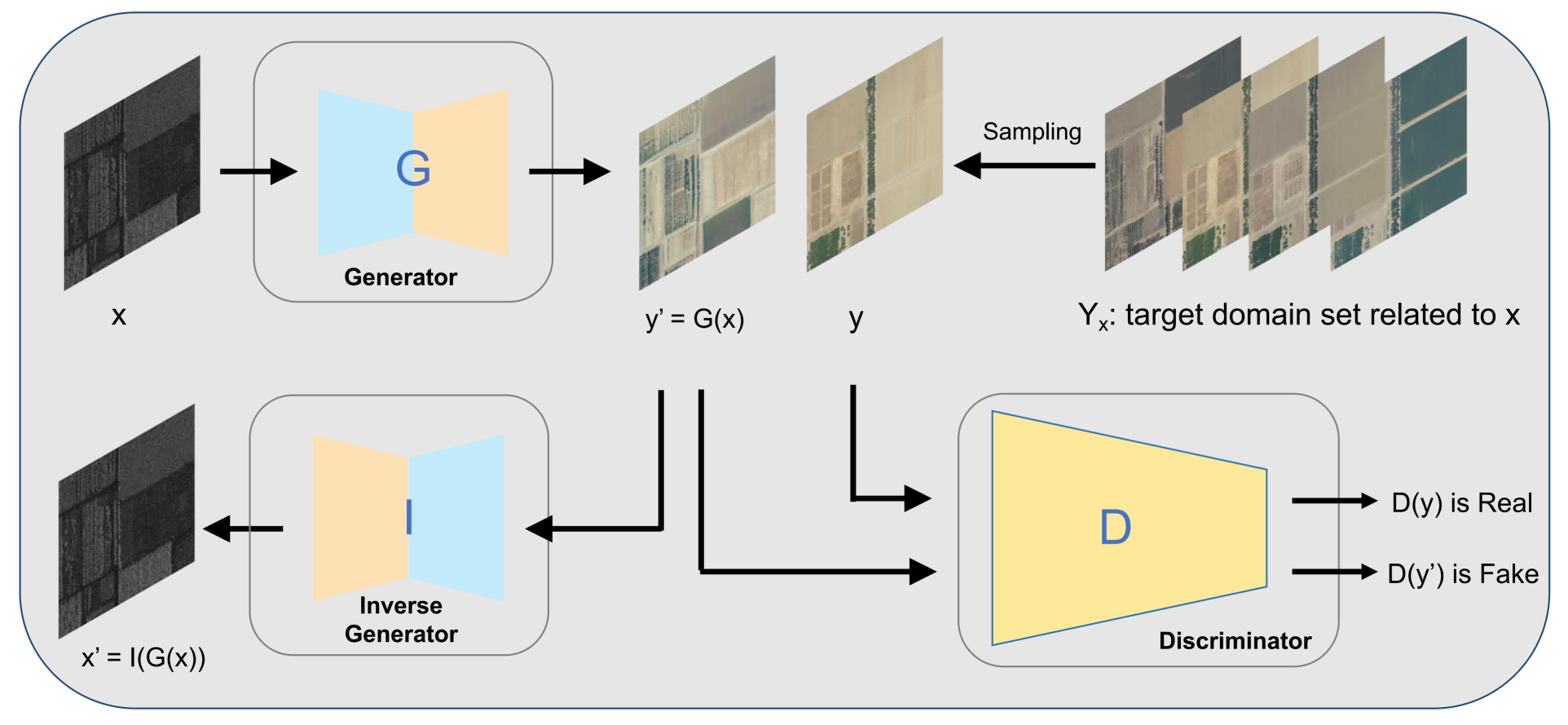

MvAV-pix2pixHD: Multi-view Aerial View Image Translation

Jun Yu, Keda Lu, Shenshen Du et al. (学生一作)

- 设计针对多视角图像翻译任务的时间优先采样和随机采样方法。

- 提出了用于多视角图像翻译的MvAV-pix2pixHD,使用了三个强大的loss。

- 该论文的方法应用于MAVIC-T竞赛中的2个多视角图像翻译任务中取得了1个冠军和1个亚军。

-

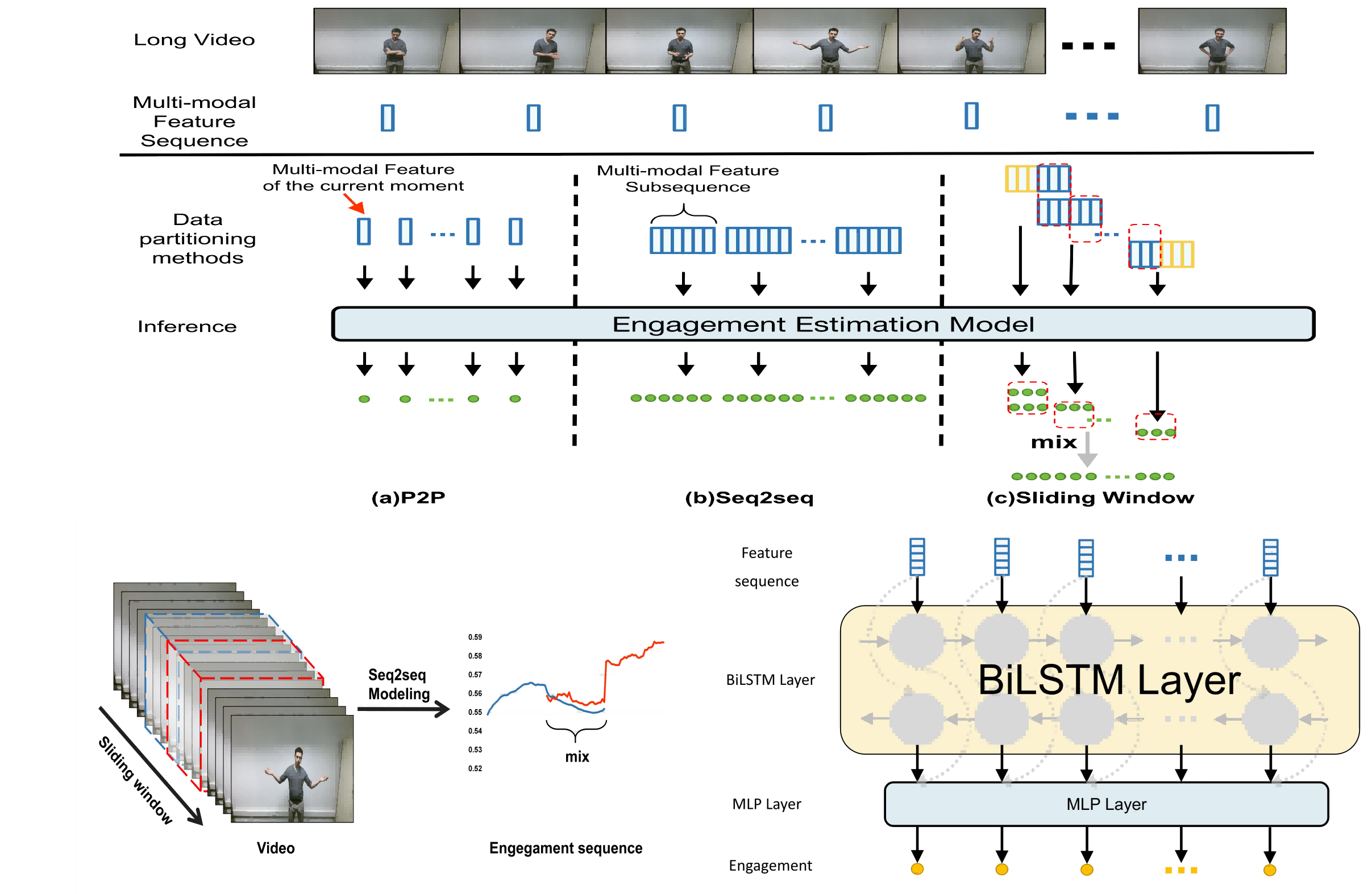

ACM-MM 2023(CCF-A)Sliding Window Seq2seq Modeling for Engagement Estimation

Jun Yu, Keda Lu, Mohan Jing et al. (学生一作) -

TOMM 2024在投(CCF-B)Exploring Seq2seq Models for Engagement Estimation in Dyadic Conversations

Jun Yu, Keda Lu, Lei Wang et al. (学生一作)

- 基于Transformer和BiLSTM模型提出Seq2seq参与度估计模型,实现了当前参与度估计任务新的SOTA。Transformer尝试4种绝对和相对位置编码,包括RoPE。

- 针对长视频直接划分遇到的上下文大量丢失问题,提出滑动窗口提升性能。

- 提出Ai-BiLSTM去对齐和交互对话者的多模态特征,进一步提升性能。

- 该论文的方法应用于ACM-MM 2023中的参与度估计竞赛中取得了冠军。

A Comprehensive and Unified Out-of-Distribution Classification Solution Framework

Jun Yu, Keda Lu, Yifan Wang et al. (学生一作)

- (数据)提出semantic masking数据增强用于提升模型针对occlusion场景的鲁棒性,并提出了OOD-DAS,一个全面且鲁棒的数据增强集合。

- (模型)提出OOD-Attention,可用于SOTA分类模型无缝集成,提升模型鲁棒性。

- (策略)提出多架构模型集成的迭代伪标签方法,进一步提升OOD识别的精度。

- 该论文的方法应用于ICCV 2023的OOD识别竞赛中取得了冠军。

-

ACM-MM 2024End-to-end Spatio-Temporal Information Aggregation For Micro-Action Detection Jun Yu, Mohan Jing, Gongpeng Zhao, Keda Lu et al. -

ACM-MM 2024Building Robust Video-Level Deepfake Detection via Audio-Visual Local-Global Interactions Yifan Wang, Xuecheng Wu, Jia Zhang, Mohan Jing, Keda Lu et al. -

ACM-MM 2023Answer-Based Entity Extraction and Alignment for Visual Text Question Answering Jun Yu, Mohan Jing, Weihao Liu, Tongxu Luo, Bingyuan Zhang, Keda Lu et al. -

CLEF 2022Bag of Tricks and a Strong Baseline for FGVC. Jun Yu, Hao Chang, Keda Lu et al. -

CLEF 2022Efficient Model Integration for Snake Classification Jun Yu, Hao Chang, Zhongpeng Cai, Guochen Xie, Liwen Zhang, Keda Lu et al. -

CVPR 2022 workshopPseudo-label generation and various data augmentation for semi-supervised hyperspectral object detection Jun Yu, Liwen Zhang, Shenshen Du, Hao Chang, Keda Lu et al. -

AAAI 2022 workshopMining limited data for more robust and generalized ML models, Jun Yu, Hao Chang, Keda Lu et al. -

International Journal of Machine Learning and CyberneticsGenerating transferable adversarial examples based on perceptually-aligned perturbation, Hongqiao Chen, Keda Lu, Xianmin Wang et al.

💻 业务项目

- 2024.03 - 至今 多模态大模型

- 2023.10 - 2024.02 贷款客户还款意愿识别

- 基于百万级别宽表数据和千万级别通话文本进行探索性数据分析(EDA)。

- EDA->数据清洗->特征工程,使用Bert对文本建模,识别客户的还款意愿。

- 尝试利用LLM对通话文本进行数据增强,提高模型鲁棒性。

- 2023.05 - 2023.09 垂直领域聊天助手(构建训练语料,基于ChatGLM、Bloomz、Qwen等lora微调对比)

- 2023.03 - 2023.06 OCR大模型展示平台(左图为本人实现demo,以防侵权)

- 使用Gradio作为前后端,搭建了整个OCR大模型展示接口,包括DocQA、MLLM和纯OCR模块。

- 本人独立维护,方便对内分析调试,对外业务展示,该项目获得2023年H1【XXX·企点荣誉激励】——技术进步奖。

- 独立负责DocQA模块,具体细节是对输入的文档、图片等采用ocr提取得到文字后,分段采用embedding后存储到数据库,根据输入的问题也进行embedding,将与之匹配的TopK个段落,一起输入LLM。

- 2023.01 - 2023.03 任意风格中文字体生成 (GAN、Diffusion model)

- 调研了中文字体生成算法,主流采用GAN,唯一一个采用了Diffusion model(Diff-Font),但其风格编码器采用的是GAN预训练的模块。

- 自行搜集400类字体数据,基于Diffusion model(DDPM)设计端到端的字体生成模型,在SSIM、LPIPS等指标上略优于Diff-Font和DG-Font,但加入风格编码的整体结构训练缓慢。

- 未来改进点:End2end、对比学习、Diffusion model

- 2022.11 - 2023.01 文档生成和风格迁移(独立调研)

- 探索Diffusion model和GAN在端到端文档生成的可能性。

- 调研了各大顶会五年来的风格迁移文章,CNN->Attention->Transformer,包括AdaIN(ICCV2017)、MetaNet(CVPR2018)、SANet(CVPR2019)、MAST(ACM-MM 2020)、StyleFormer(ICCV2021)、AdaAttN(ICCV2021)和StyTr2(CVPR2022)。

- 复现其中的StyTr2(CVPR2022)和AdaAttN(ICCV2021),并迁移到文档生成任务中,用于数据增强。

- 未来改进点:对比学习、GAN、Diffusion model

- 2022.06 - 2022.12 基于Mindspore算法框架复现主流算法

- 参与复现了RetinaFace人脸检测算法

- 独立复现了FCENet文本检测算法

🏅 参与竞赛

研究生阶段(主要参与)

-

2024.07 ACM-MM 2024: Grand challenge, Multi-Domain Engagement Estimation (个人solo, 冠军🏆) [排行榜]

-

2024.03 CVPR 2024: Multi-modal Aerial View Image Challenge - Translation (Top3奖金池2500$, 个人solo, 亚军🥈) [排行榜] [论文]

-

2023.10 ICCV 2023: Out Of Distribution Generalization: Object Classification track (个人solo, 冠军🏆) [排行榜] [论文在投]

-

2023.10 ICCV 2023: Out Of Distribution Generalization: Pose Estimation track (个人solo, 冠军🏆) [排行榜] [技术报告]

-

2023.07 ACM-MM 2023: Grand challenge, Engagement Estimation (个人solo, 冠军🏆) [排行榜] [论文] [新闻]

-

2022.10 ECCV 2022: Out Of Distribution Generalization Track-1: Object Classification (Top3奖金池3300$, 个人solo, 亚军🥈) [排行榜] [代码]

-

2022.10 ECCV 2022: Out Of Distribution Generalization Track-2: Object Detection (Top3奖金池3300$, 亚军🥈) [排行榜] [代码]

-

2022.05 CVPR 2022: FGVC9 workshop FungiCLEF2022 challenge (亚军🥈) [排行榜] [代码] [论文]

-

2022.03 CVPR 2022: Multi-modal Aerial View Object Classification - Track 2 (SAR+EO) (Top3奖金池6000$, 冠军🏆) [排行榜] [技术报告] [新闻]

-

2022.03 CVPR 2022: Multi-modal Aerial View Object Classification - Track 1 (SAR) (Top3奖金池6000$, 冠军🏆) [排行榜] [技术报告] [新闻]

研究生阶段(协助参与)

-

2024.07 ACM-MM 2024: 1M-Deepfakes Detection Challenge (冠军🏆) [排行榜] [论文]

-

2024.07 ACM-MM 2024: Micro-Action Analysis Grand Challenge:Multi-label Micro-Action Detection (冠军🏆) [排行榜] [论文]

-

2024.07 ACM-MM 2024: Micro-Action Analysis Grand Challenge:Micro-Action Detection (亚军🥈) [排行榜] [论文]

-

2023.12 ICCV 2023: WECIA - Caption Generation Challenge (冠军🏆) [排行榜]

-

2023.07 ACM-MM 2023: Visual Text Question Answering (季军🥉) [排行榜] [论文]

-

2023.03 CVPR 2023: Multi-modal Aerial View Imagery Challenges - Translation (Top3奖金池2250$, 冠军🏆) [排行榜] [论文]

-

2022.06 CVPR 2022: Robustness in Sequential Data challenge (冠军🏆) [排行榜] [技术报告] [新闻]

-

2022.03 CVPR 2022: Semi-Supervised Hyperspectral Object Detection Challenge (冠军🏆) [排行榜] [论文]

本科生阶段

-

2022.08 中国高校计算机大赛—微信大数据挑战赛 (前十奖金池56万¥, 个人solo, 全国二等奖, Top30/3000+) [排行榜] [代码]

-

2022.01 AAAI 2022:以数据为中心的鲁棒机器学习竞赛 (前十奖金池100万¥, 个人solo, 初赛2/3692, 复赛10/3692) [排行榜] [代码] [论文]

-

2021.11 OPPO安全AI挑战赛-人脸识别攻击 (前十奖金池60万¥, 个人solo, 初赛6/2000+, 复赛12/2000+) [排行榜] [代码]

-

2021.03 CVPR 2021:防御模型的白盒对抗攻击 (前十奖金池10万$, 个人solo, 排名20/1681) [排行榜] [代码] [博客]

-

2020.10 伪造图像的对抗攻击竞赛(阿里天池和清华大学联合举办) (前十奖金池200万¥, 排名6/1666) [排行榜]

-

2020.08 腾讯广告算法大赛 (前十奖金池10万$, 初赛第6名, 复赛第11名, 1万+人参加) [代码] [博客]

-

2020.04 二手车交易价格预测正式赛(阿里天池联合Datawhale举办) (个人solo, 优胜奖, 排名13/2815) [排行榜] [代码] [博客]

-

2020.03 文本分类对抗攻击竞赛(阿里天池和清华大学联合举办) (前十奖金池6.8万¥, 排名4/1666) [排行榜] [代码] [博客]

-

2019.12 ImageNet图像分类对抗(阿里天池和清华大学联合举办) (前十奖金池6.8万¥, 排名5/1522) [排行榜] [博客]

-

2019.10 国际安全极客大赛(GeekPwn2019)CAAD CTF总决赛 (总决赛奖金池10万¥,上海总决赛第五名, 唯一本科生队伍) [排行榜] [新闻]

🎖 荣誉奖项

- 2025.03 安徽省优秀毕业生

- 2025.03 中国科学技术大学优秀毕业生

- 2024.10 国家奖学金(研究生前1%)

- 2023.11 华为奖学金(全校30位)

- 2023.10 国家奖学金(研究生前1%)

- 2022.10 国家奖学金(研究生前1%)

- 2021.10 国家奖学金(本科前1%)

- 2020.10 国家奖学金(本科前1%)

🎓 教育

🏛️ 学术会议

- 2024.03, 昇思人工智能框架产业峰会(华为主办), 受华为邀请, 北京。

- 2023.11, 第31届ACM多媒体国际会议, 渥太华, 加拿大。

- 2020.12, 第一届AI与安全研讨会(清华大学人工智能研究院和阿里安全共同主办), 受阿里巴巴邀请, 北京。

- 2019.10, 第五届GeekPwn国际安全极客大赛, 上海。

💻 工作经历

- 2025.06 - 至今, 华为, 终端云服务小艺业务部

- 2023.10 - 2025.06, 平安科技(实习), 美国硅谷研究院

- 2023.04 - 2023.06, 网易(实习), 伏羲实验室

- 2022.11 - 2023.09, 腾讯(实习), 优图实验室

- 2022.06 - 2022.12, 华为(实习), 2012实验室

Thank you very much for every visitor, and I look forward to hearing from you!